OpenHarmony带你玩转DeepSeekR1大模型

1. 环境准备选择Ubuntu 20.04.3 LTS作为我们的linux开发环境,组织编译工具为cmake,还需要提前准备能编译openHarmony源码工程的环境,不会搭建oenHarmony编译环境的可以参考该链接。 https://gitee.com/rkl_212/Documents/blob/master/Ubuntu%E9%85%8D%E7%

1. 环境准备

选择Ubuntu 20.04.3 LTS作为我们的linux开发环境,组织编译工具为cmake,还需要提前准备能编译OpenHarmony源码工程的环境,不会搭建OpenHarmony编译环境的可以参考该链接。 https://gitee.com/rkl_212/Documents/blob/master/Ubuntu%E9%85%8D%E7%BD%AEOpenHarmony%E5%BC%80%E5%8F%91%E7%8E%AF%E5%A2%83.md

2. 环境配置

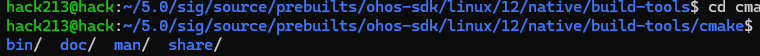

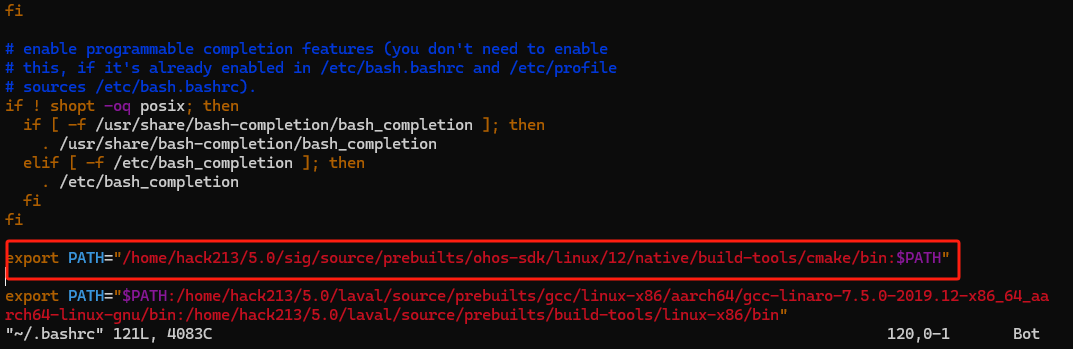

把OpenHarmony中sdk的编译工具cmake添加到环境变量PATH中;

把cmake所在路径,添加到PATH中去:

vim ~/.bashrc

3. llama.cpp源码拉取

使用如下指令准备llama.cpp的source code:

git clone https://github.com/ggml-org/llama.cpp.git

cd llama.cpp使用如下指令生成Makefile:

cmake \

-DCMAKE_TOOLCHAIN_FILE=/home/hack213/5.0/sig/source/prebuilts/ohos-sdk/linux/12/native/build/cmake/ohos.toolchain.cmake \

-DANDROID_ABI=arm64-v8a \

-DANDROID_PLATFORM=OHOS \

-DCMAKE_C_FLAGS="-march=armv8.7a" \

-DCMAKE_CXX_FLAGS="-march=armv8.7a" \

-DGGML_OPENMP=OFF \

-DGGML_LLAMAFILE=OFF \

-B build

注意:DCMAKE_TOOLCHAIN_FILE中路径填写自己项目实际路径

使用如下指令开始编译:

cmake --build build --config Release

进去build/bin目录下,验证编译产物:

查看是否是aarch64架构的程序:

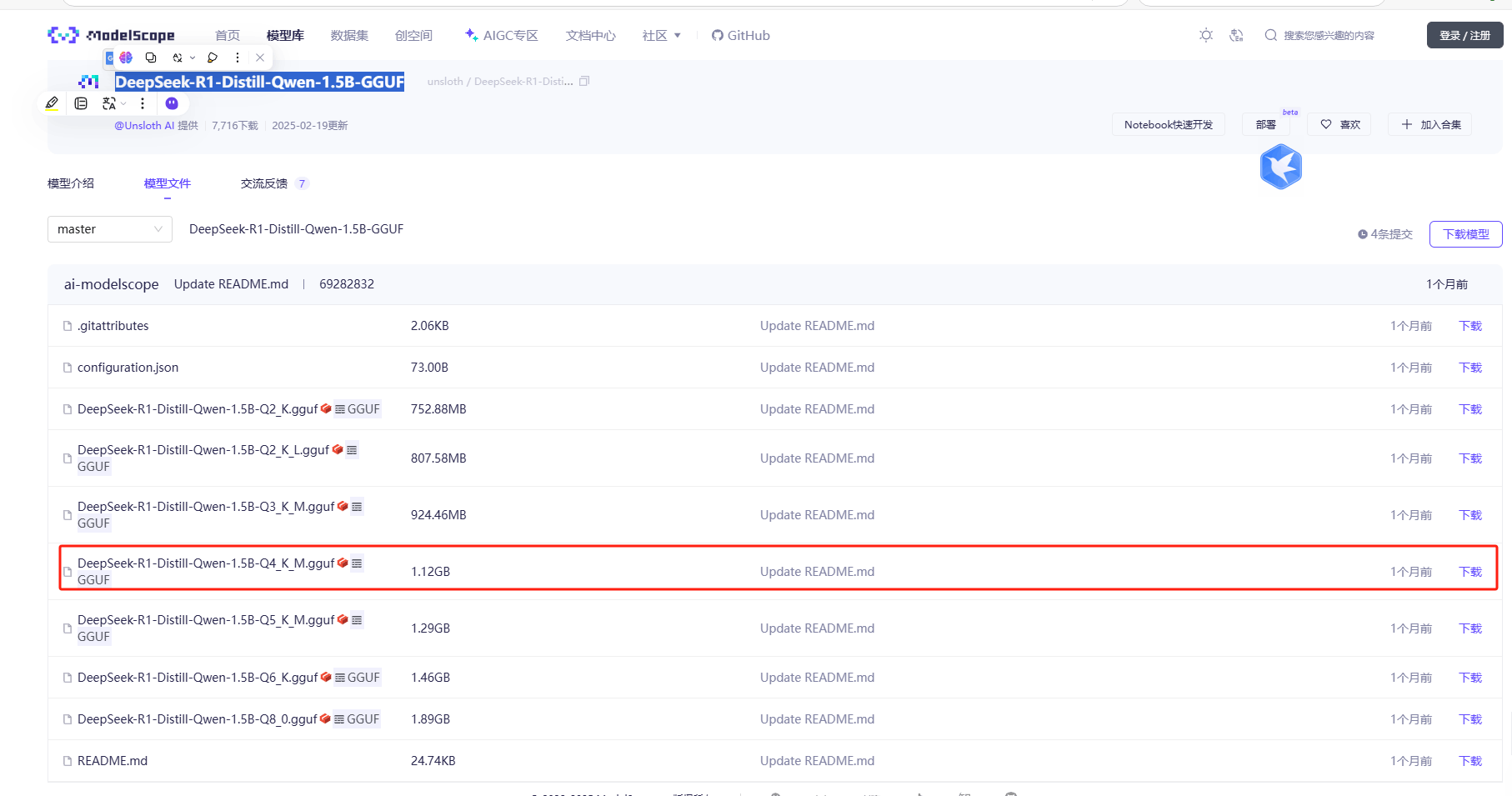

4.下载DeepSeek-R1模型

在魔塔社区https://modelscope.cn/中下载DeepSeek-R1-Distill-Qwen-1.5B-GGUF模型

提示:使用迅雷下载可以加载下载速度

5.0 运行llama.cpp

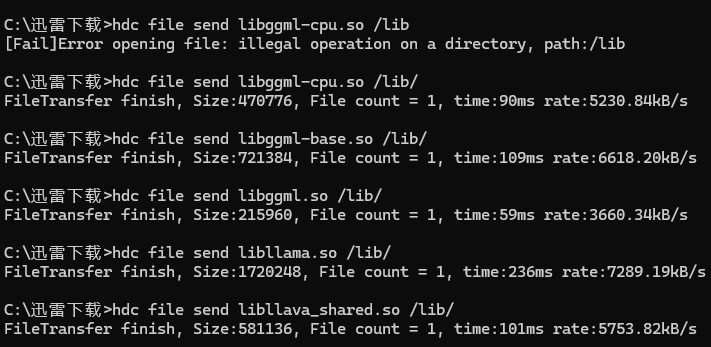

使用hdc把刚刚编译的libggml-base.so ,libggml-cpu.so,libggml.so ,libllama.so,libllava_shared.so推送到开发者手机/lib/中

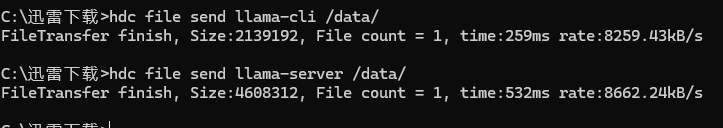

使用hdc把刚刚编译出来的llama-cli,llama-server推送到开发者手机中/data/中

使用hdc把刚刚下载的DeepSeek-R1-Distill-Qwen-1.5B-Q4_K_M.gguf大模型推送到开发者手机/data/中

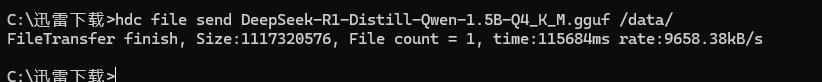

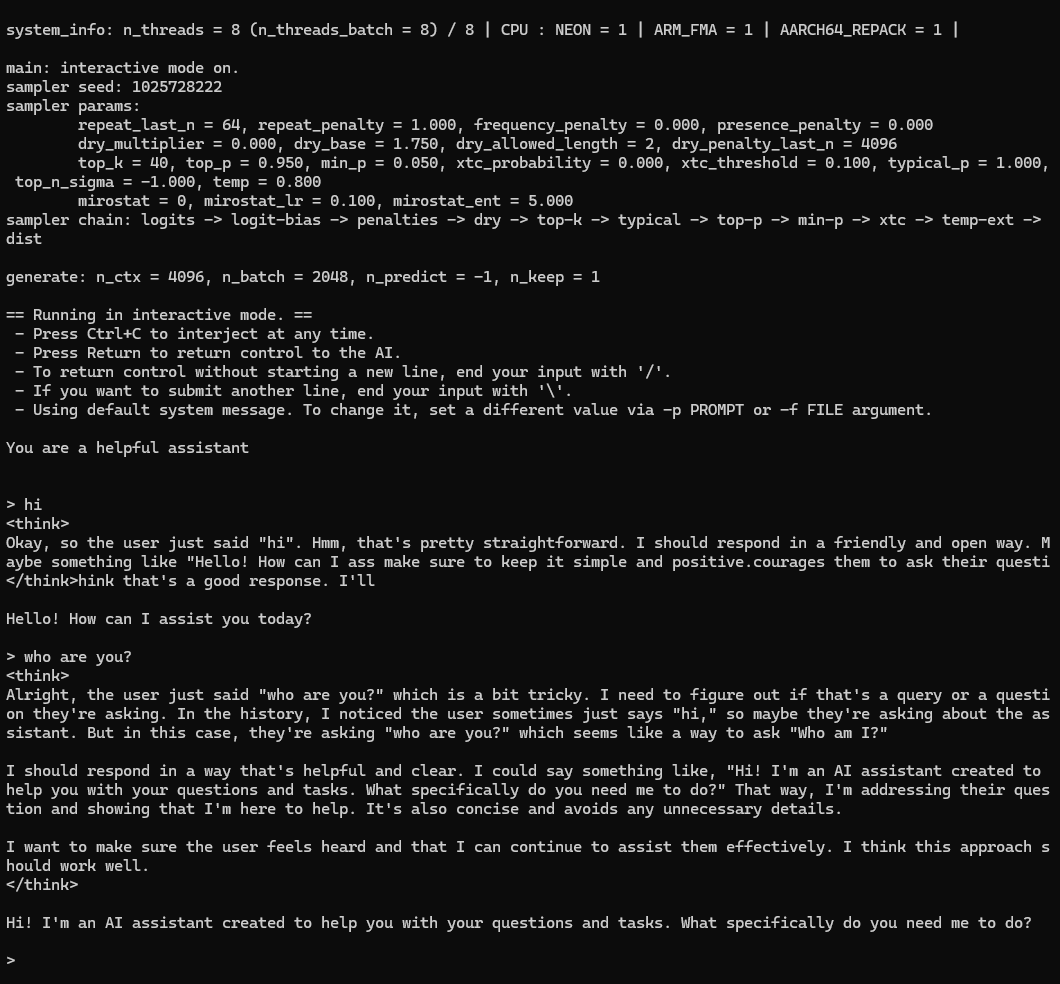

运行console端:

C:\迅雷下载>hdc shell

# cd data

# chmod a+x lla

llama-cli llama-server

# chmod a+x llama-cli

./llama-cli -m ./DeepSeek-R1-Distill-Qwen-1.5B-Q4_K_M.gguf

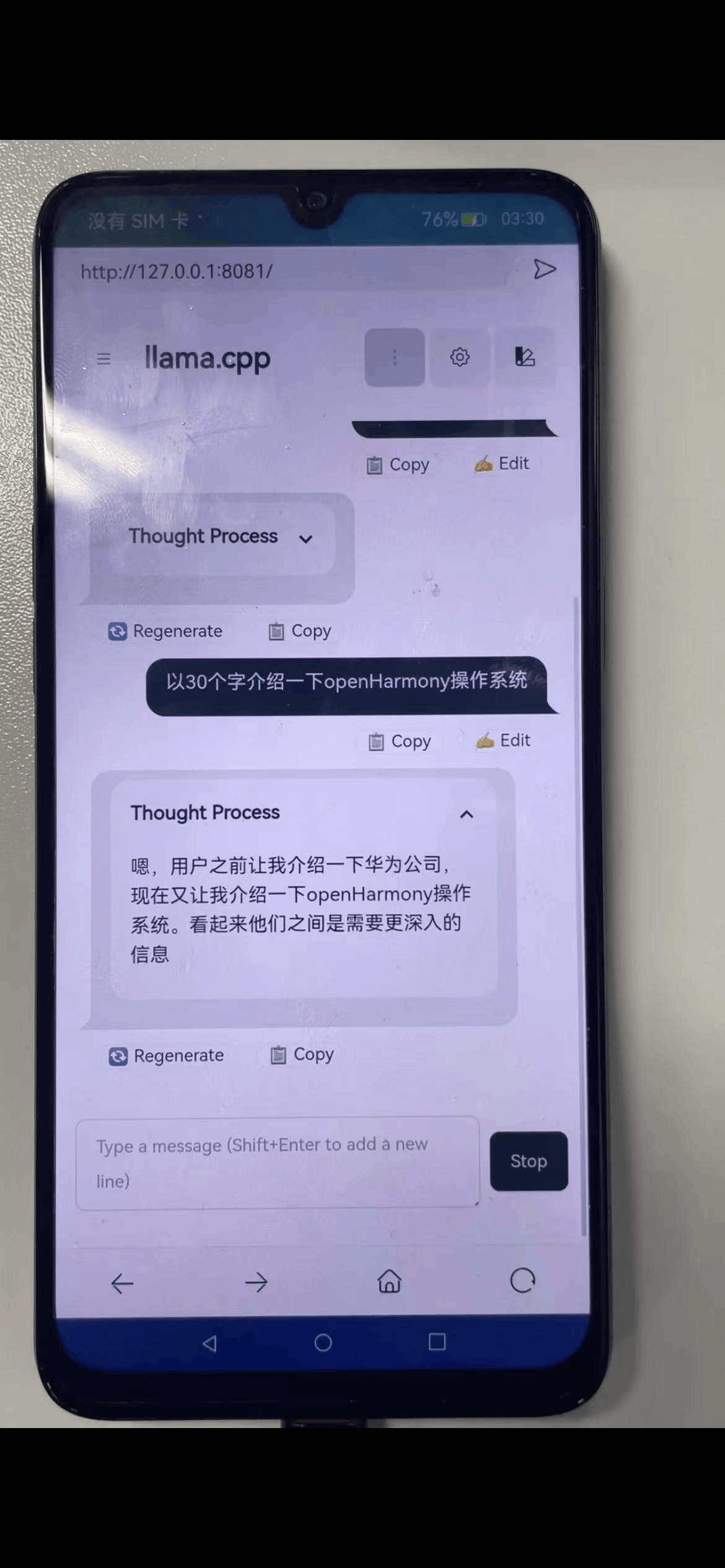

运行带web版:

C:\迅雷下载>hdc shell

# cd data

# chmod a+x lla

llama-cli llama-server

# chmod a+x llama-server

./llama-server -m ./DeepSeek-R1-Distill-Qwen-1.5B-Q4_K_M.gguf --port 8081

使用浏览器开打:http://127.0.0.1:8081

注意:不是https,而是http

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)